有沒有想過是否可以在 Mac 上本地運行 ChatGPT 之類的東西而無需互聯網?只需進行一些設置,您實際上就可以了。那也是免費的。無論您是想保持聊天的私密性還是只想離線訪問 AI,您都可以通過以下方法在 Mac 上本地運行強大的大型語言模型。

#圖片標題

在我們深入研究並檢查設置之前,您需要以下內容:

如何在 Mac 上本地運行 LLM

我們將使用一個名為的免費工具成為,只需幾個命令即可在本地下載並運行 LLM。以下是如何開始:

第1步:安裝Homebrew(如果已安裝則跳過)

Homebrew 是 macOS 的包管理器,可幫助您從終端應用程序安裝應用程序。如果您的 Mac 上已經安裝了 Homebrew,則可以跳過此步驟。但如果您不這樣做,安裝方法如下:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"brew doctor

如果您看到“您的系統已準備好沖泡”,那麼就可以開始了。

如果您遇到任何問題或想要更詳細的分步過程,請查看我們有關如何在 Mac 上安裝 Homebrew 的指南。

第2步:安裝並運行Ollama

現在 Homebrew 已安裝並可以在 Mac 上使用,讓我們安裝 Ollama:

brew install ollamaollama serve

保持此窗口打開或最小化。此命令使 Ollama 在後台運行。

或者,下載奧拉馬應用程序並像任何常規 Mac 應用程序一樣安裝它。完成後,打開應用程序並使其在後台運行。

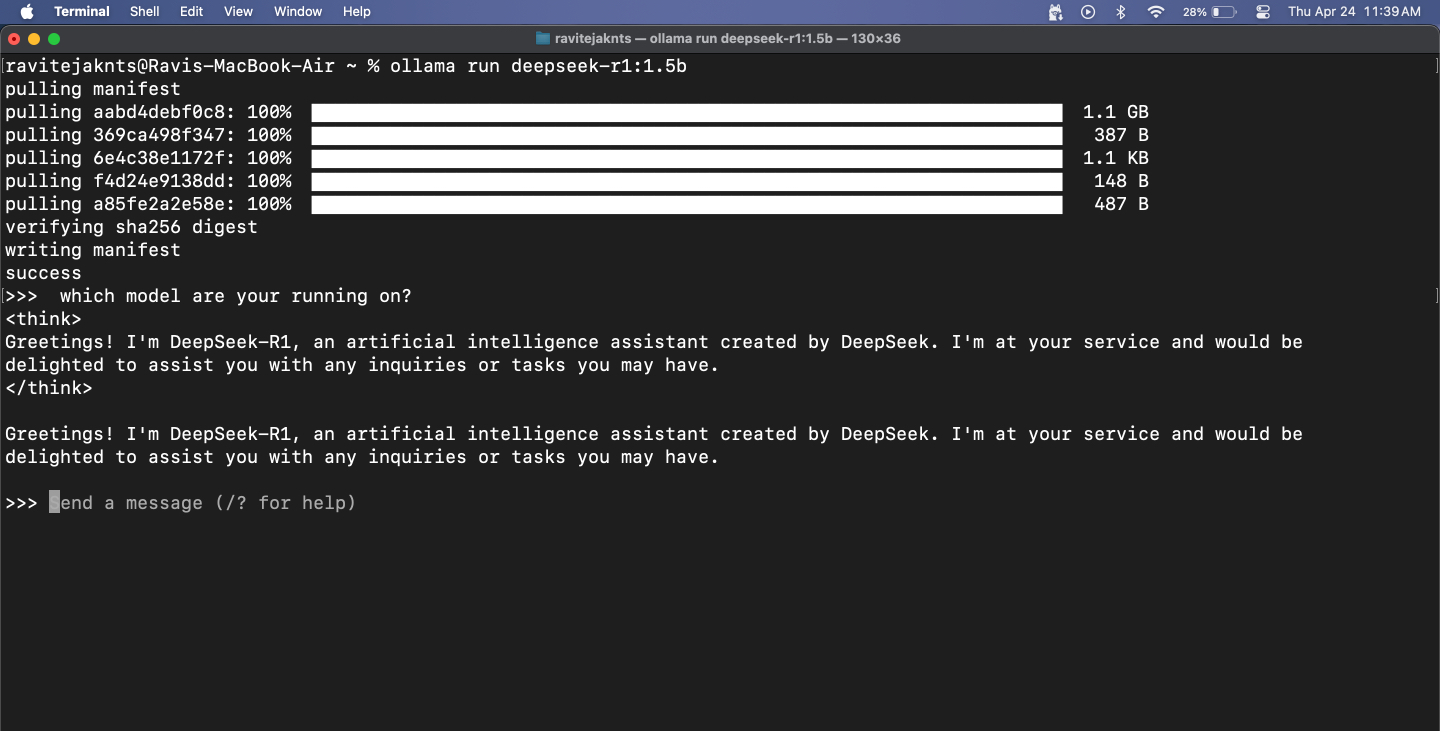

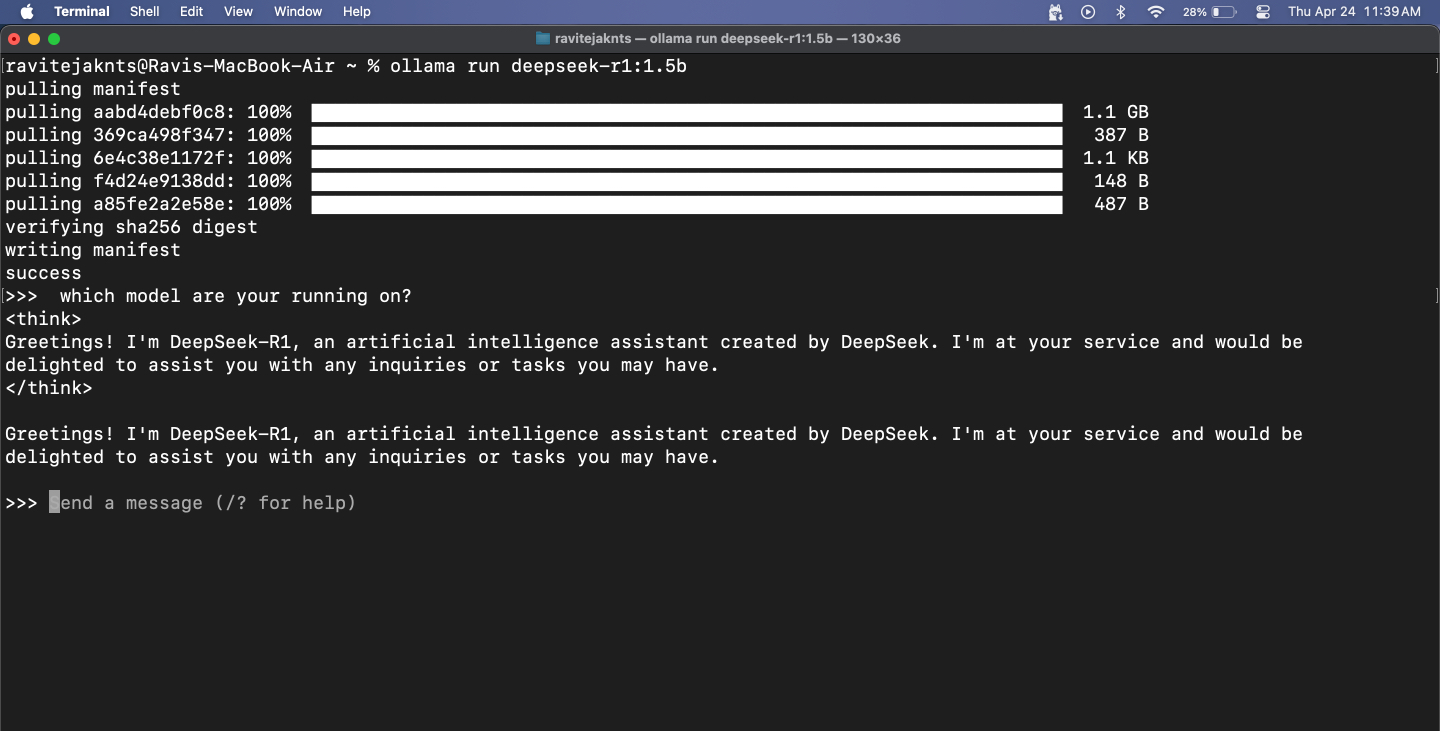

第 3 步:下載並運行模型

Ollama 讓您可以訪問流行的法學碩士,如 DeepSeek、Meta's Llama、Mistral、Gemma 等。您可以通過以下方式選擇並運行其中一個:

如果您選擇大型型號,則可能會出現一些延遲,畢竟整個模型都在您的 MacBook 上本地運行。較小的模型響應速度更快,但它們可能會難以準確,特別是對於數學和邏輯相關的任務。另外,請記住,由於這些模型無法訪問互聯網,因此它們無法獲取實時信息。

也就是說,對於檢查語法、寫電子郵件或集思廣益之類的事情,它們非常有效。我在 MacBook 上廣泛使用了 DeepSeek-R1,並具有 Web UI 設置,它還允許我上傳圖像和粘貼代碼片段。雖然它的答案(尤其是其編碼技能)不如 ChatGPT 或 DeepSeek 671B 等頂級模型那麼敏銳,但它仍然可以在不需要互聯網的情況下完成大多數日常任務。

第 4 步:在終端中與模特聊天

模型運行後,您只需輸入消息並點擊返回。該模型將在下面做出響應。

要退出會話,請按控制+D在你的鍵盤上。當您想再次開始聊天時,只需使用相同的ollama run [model-name]命令。由於模型已下載,因此它將立即啟動。

第 5 步:查看和管理已安裝的模型

要檢查當前下載了哪些模型,請運行:

ollama list

要刪除不再需要的模型,請使用:

ollama rm [model-name]獎勵:在 Web 上使用帶有 UI 的 Ollama

當 Ollama 在終端中運行時,它還會在 https://localhost:11434 啟動本地 API 服務,允許您將其連接到 Web 界面,以便與模型進行可視化交互 - 類似於使用聊天機器人。一種流行的選擇是 Open WebUI,它在 Ollama 的核心功能之上提供了一個用戶友好的界面。讓我們看看如何設置它。

第1步:安裝Docker

Docker 是一種工具,可讓您將程序及其所有基本元素打包到便攜式容器中,以便您可以在任何設備上輕鬆運行它。我們將使用它為您的 AI 模型打開基於網絡的聊天界面。

建議閱讀:谷歌宣布推出新的法學碩士 Gemini 1.0,與 ChatGPT-4 競爭

如果您的 Mac 尚未安裝 Docker,請按照以下步驟安裝 Docker:

docker --version

如果該命令返回版本號,則表示您的 Mac 上已安裝 Docker。

步驟 2:拉取 Open WebUI 鏡像

Open WebUI 是一個簡單的工具,可在瀏覽器中為您提供一個聊天窗口。拉取鏡像僅意味著下載運行鏡像所需的文件。

為此,請轉至終端應用程序和類型:

docker pull ghcr.io/open-webui/open-webui:main這將下載該界面所需的文件。

步驟3:運行Docker容器並打開WebUI

現在,是時候使用 Docker 運行 Open WebUI 了。您將看到一個乾淨的界面,您可以在其中與 AI 聊天,無需終端。您需要執行以下操作:

docker run -d -p 9783:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

https://localhost:9783/

從這裡,您可以在乾淨、用戶友好的瀏覽器界面中與任何已安裝的模型聊天。此步驟是可選的,但它可以讓您在不使用終端的情況下獲得更流暢的聊天體驗。

你的 Mac,你的 AI:沒有服務器,沒有字符串

就是這樣!只需幾個步驟,您就可以將 Mac 設置為完全離線運行強大的 AI 模型。設置後無需帳戶、無需雲、也無需互聯網。無論您想要私人對話、本地文本生成,還是只是想嘗試法學碩士,Ollama 都可以讓您輕鬆訪問,即使您不是開發人員。嘗試一下!

也請查看這些有用的指南: